En ce beau jour du 06 juin 2024, la question de l’optimisation des performances des systèmes de stockage et de traitement de données massives est plus que jamais d’actualité. L’ère du Big Data est bel et bien installée, et avec elle, l’importance cruciale de la gestion optimale de ces données. Une technologie ressort tout particulièrement du lot, largement utilisée pour le stockage et le traitement de ces volumes massifs de données : Hadoop. Cette plateforme open-source, développée par Apache, repose sur l’usage de clusters, des groupes de noeuds de calcul connectés entre eux. Mais comment tirer le meilleur parti de ces clusters Hadoop ? Voyons ensemble les stratégies pour optimiser leurs performances.

Le choix judicieux du système de stockage

Avant de se lancer dans le monde du Big Data, il est primordial d’opter pour le système de stockage adéquat. En effet, le choix du système de stockage est déterminant pour les performances d’un cluster Hadoop. Le système de fichiers distribué de Hadoop, ou HDFS, est le plus couramment utilisé. Il divise les données en blocs de taille fixe, généralement de 128 Mo, et les répartit sur les différents noeuds du cluster.

Mais n’oubliez pas que d’autres systèmes de stockage existent et peuvent être plus adaptés à vos besoins spécifiques. Par exemple, si votre travail implique de nombreuses opérations de lecture et d’écriture, un système de stockage basé en mémoire, comme Apache Spark, pourrait être une meilleure option. Il offre des performances de traitement de données plus rapides que HDFS, notamment pour les tâches itératives.

Utilisation efficace de MapReduce

MapReduce est une composante essentielle de Hadoop, un modèle de programmation qui permet de traiter et de générer de grands ensembles de données. Son utilisation adéquate peut grandement améliorer les performances de votre cluster Hadoop.

Pour commencer, assurez-vous de bien comprendre le fonctionnement de MapReduce. Ses deux principales phases, Map et Reduce, sont exécutées en parallèle sur différents noeuds du cluster. L’optimisation de ces deux phases est donc cruciale. Par exemple, il est conseillé d’écrire des fonctions Map et Reduce qui minimisent le temps de calcul et la quantité de données transférées sur le réseau.

L’importance de la configuration des noeuds

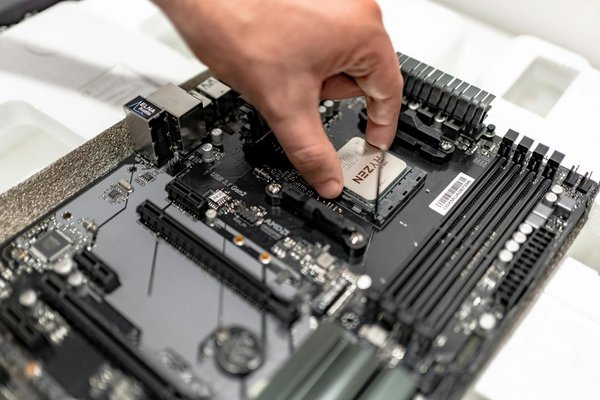

Dans un cluster Hadoop, chaque noeud est un serveur indépendant capable de stocker des données et d’exécuter des tâches. Ainsi, la configuration de ces noeuds peut avoir un impact significatif sur les performances globales du cluster.

Il est conseillé d’équilibrer soigneusement la capacité de stockage et la puissance de calcul de chaque noeud. Un noeud avec une grande capacité de stockage mais une faible puissance de calcul pourrait devenir un goulot d’étranglement pour les tâches de traitement de données. De même, un noeud avec une forte puissance de calcul mais une faible capacité de stockage risque de ne pas être utilisé de manière optimale.

L’adoption de l’informatique dans le Cloud

Avec l’évolution rapide de la technologie, l’informatique en cloud est devenu un choix populaire pour le stockage et le traitement de grandes quantités de données. L’utilisation du cloud pour héberger votre cluster Hadoop peut offrir plusieurs avantages en termes de performances.

Tout d’abord, le cloud offre une grande flexibilité. Vous pouvez facilement augmenter ou diminuer la taille de votre cluster en fonction de vos besoins. De plus, le cloud permet une mise à l’échelle automatique, où de nouveaux noeuds sont ajoutés ou retirés en fonction de la charge de travail. Cette flexibilité peut augmenter l’efficacité de votre cluster et réduire les coûts.

Surveiller les performances

Enfin, pour optimiser les performances de votre cluster Hadoop, il est essentiel de surveiller régulièrement son fonctionnement. Des outils comme Apache Ambari ou Cloudera Manager peuvent vous aider à suivre les performances de votre cluster en temps réel.

Ces outils fournissent des informations détaillées sur l’utilisation des ressources, les performances des tâches et l’état de santé général du cluster. Ils permettent également de détecter rapidement les problèmes et d’intervenir pour résoudre les problèmes avant qu’ils n’affectent les performances globales.

Finalement, optimiser un cluster Hadoop est un processus qui demande une compréhension approfondie du fonctionnement de la plateforme et une capacité à adapter cette connaissance à vos besoins spécifiques. En suivant ces conseils, vous serez en mesure d’augmenter significativement les performances de votre cluster Hadoop et d’exploiter au mieux le potentiel du Big Data.

L’exploitation des machines virtuelles avec Google Cloud

Aujourd’hui, l’informatique en nuage offre de nouvelles possibilités pour le traitement des données massives, et Google Cloud s’impose comme l’un des leaders de ce domaine. En effet, la plateforme de Google se prête particulièrement bien à l’utilisation de clusters Hadoop, notamment grâce à ses machines virtuelles.

En utilisant Google Cloud pour héberger votre cluster Hadoop, vous bénéficiez de la flexibilité et de la puissance de calcul de ses machines virtuelles. Ces dernières peuvent être configurées pour répondre précisément à vos besoins, que ce soit en termes de puissance de calcul, de capacité de stockage ou de bande passante réseau. De plus, grâce à l’infrastructure globale de Google, votre cluster peut être déployé dans n’importe quelle région du monde, ce qui peut réduire la latence et améliorer les performances pour les utilisateurs locaux.

De plus, Google Cloud offre une gamme d’outils dédiés à la gestion des données. Par exemple, Google Cloud Storage est une solution de stockage durable, hautement disponible et évolutive pour vos données Hadoop. De même, Google Cloud Dataproc est un service rapide, facile à utiliser et entièrement géré pour exécuter vos jobs Apache Spark et Apache Hadoop.

Enfin, il convient de mentionner que Google Cloud offre également des services de sauvegarde et de restauration, essentiels pour la protection des données. En cas de défaillance d’un noeud ou de perte de données, ces services permettent de restaurer rapidement l’état de votre cluster, minimisant ainsi le temps d’arrêt et la perte de données.

Le rôle de l’écosystème Hadoop dans l’optimisation des performances

L’écosystème Hadoop regroupe l’ensemble des outils et des services conçus pour travailler avec Hadoop. Cet écosystème joue un rôle crucial dans l’optimisation des performances des clusters Hadoop, car il offre une grande flexibilité et de nombreuses options pour le traitement des données.

Premièrement, l’écosystème Hadoop comprend plusieurs systèmes de fichiers distribués, comme Hadoop HDFS, Hadoop KFS, ou encore Google Cloud Storage. Chacun de ces systèmes a ses propres caractéristiques et avantages, et le choix du bon système de fichiers peut avoir un impact majeur sur les performances de votre cluster.

Deuxièmement, l’écosystème Hadoop comprend également une variété de modèles de programmation, comme MapReduce, Spark, ou Flink. Ces modèles permettent de traiter les ensembles de données de différentes manières, et le choix du bon modèle peut également influencer les performances de votre cluster.

Enfin, l’écosystème Hadoop offre aussi des outils pour la sauvegarde et la restauration des données, pour la surveillance des performances, pour la gestion des ressources, et bien plus encore. En utilisant ces outils adéquatement, vous pouvez améliorer significativement les performances de votre cluster Hadoop.

L’optimisation des performances des clusters Hadoop est une tâche complexe qui nécessite une bonne compréhension des différentes composantes de Hadoop, ainsi que des stratégies et des outils disponibles. Que ce soit par le choix judicieux du système de stockage, l’utilisation efficace de MapReduce, la configuration optimale des noeuds, l’adoption de l’informatique dans le cloud avec Google Cloud, l’exploitation de l’écosystème Hadoop ou encore la surveillance constante des performances, chaque aspect compte et peut contribuer à améliorer les performances de votre cluster.

En cette ère du Big Data, la maîtrise de ces techniques d’optimisation peut faire la différence entre un projet réussi et un projet qui peine à délivrer de la valeur. Alors n’hésitez pas à vous approprier ces conseils et à les mettre en pratique pour tirer le meilleur parti de vos clusters Hadoop.